MicrosoftのAI研究部門は、2020年7月から始まり、公開のGitHubリポジトリにオープンソースのAI学習モデルを共有する過程で、重大なデータ漏洩事件を引き起こしていました。この事実は、ほぼ3年後の最近になってクラウドセキュリティ専門企業Wizによって発見されました。Wizのセキュリティリサーチャーは、Microsoftの従業員が誤って漏洩情報を含むAzure BlobストレージバケットのURLを共有したことを明らかにしました。

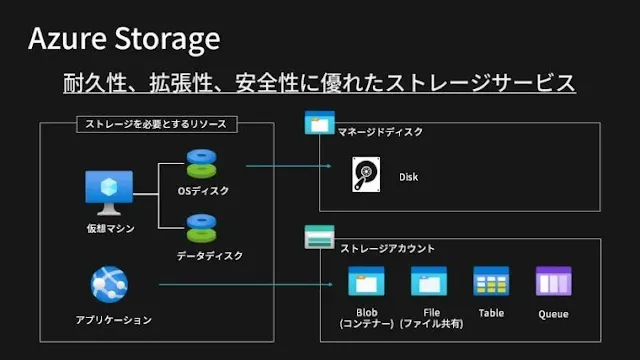

このデータ漏洩は、過度に許容的なShared Access Signature(SAS)トークンの使用に関連しているとMicrosoftは述べています。このAzureの機能は、データ共有を可能にし、しかしWizの研究者によれば、この機能は監視と取り消しに難航すると説明されています。正しく使用される場合、SASトークンは、ストレージアカウント内のリソースへの委任アクセスを安全に許可する手段を提供します。これには、クライアントのデータアクセスに対する正確な制御、彼らが対話できるリソースの指定、これらのリソースに対する権限の定義、およびSASトークンの有効期間の決定が含まれます。

Wizは警告して、監視とガバナンスの不足のため、SASトークンはセキュリティリスクをもたらし、その使用はできる限り制限されるべきであると述べています。これらのトークンは非常に追跡が困難で、MicrosoftはAzureポータル内でこれらを管理するための集中化された方法を提供していないためです。さらに、これらのトークンは効果的に永続的に設定され、有効期限に上限がないため、Account SASトークンを外部共有に使用することは安全ではなく、避けるべきであるとも述べています。

Wizの研究チームは、オープンソースモデルの他に、この内部ストレージアカウントは38TBの追加のプライベートデータへのアクセスも誤って許可していたことを発見しました。漏れたデータには、Microsoft社員の個人情報のバックアップ、Microsoftサービスのパスワード、秘密キー、および359名のMicrosoft社員からの30,000以上の内部Microsoft Teamsメッセージのアーカイブが含まれていました。この事件に対するMicrosoft Security Response Center (MSRC) チームのアドバイザリーでは、顧客データは漏洩せず、他の内部サービスもこの事件のために危険にさらされていないとMicrosoftは述べています。

出典:Microsoft leaks 38TB of private data via unsecured Azure storage