nordot.app/86883014633173…

雑記系ブログ。セキュリティとか、マイルとか、投資とか、、、 / Miscellaneous Blogs. Security, miles, investments, etc

滋賀県のデジタル商品券、不正アクセス相談900件超 クレカ利用明細確認を

nordot.app/86883014633173…

退任した役員が会社を設立して、元会社とそっくりの製品を作って売り出した結果裁判沙汰になったらどうなるか?

ビジネスソフトウェアの表示画面に関する著作権侵害の成否 東京地判令3.9.17(平30ワ28215)

事案の概要

K社は,売上分析,在庫管理,商品の発注・仕入れ・返品管理,ロケーション管理,棚卸等の様々な書店業務を効率的に行うための書店業務管理を行うASPシステム(製品K)を提供していた。

B社も,同様に書店業務管理を行う業務システム(製品B)を提供していた(B社の代表者B代表は,K社の元取締役であり,退任後,B社を設立している。)。

K社は,B社に対し,製品Bの表示画面は,製品Kの表示画面を複製又は翻案したものであるとして,著作権法112条に基づく販売等の差止めと,民法709条に基づく約4200万円の損害賠償等を求めた。

ここで取り上げる争点

(1)表示画面の複製又は翻案該当性

(2)編集著作物としての著作権侵害の成否

裁判所の判断

(1)各表示画面の複製又は翻案該当性

裁判所は,いわゆる江差追分事件最高裁判決(最判平13.6.28)等を引用して一般論を述べたのに続いて,本件の対象となっているビジネスソフトウェアの表示画面における複製又は翻案該当性について次のように述べた(改行その他文意を変更しない程度での引用上の編集を行っている。)。

製品K及び製品Yの画面表示は,その表示形式及び表示内容に照らすと,「図形の著作物」(著作権法10条1項6号)に類するものであると解されるが,両製品は,一定の業務フローを実現するため,単一の画面表示で完結することなく,業務の種類に応じて複数の画面を有し,一つの画面から次の画面に遷移することを可能にするなどして,利用者が同一階層又は異なる階層に設けられた複数の表示画面間を移動しつつ作業を行うことが想定されている。

このようなビジネスソフトウェアの表示画面の内容や性質等に照らすと,本件において製品B表示画面が製品K表示画面の複製又は翻案に該当するかどうかは,

①両表示画面の個々の画面を対比してその共通部分及び相違部分を抽出し,

②当該共通部分における創作性の有無・程度を踏まえ,製品Bの各表示画面から製品Kの相当する各表示画面の本質的な特徴を感得することができるかどうかを検討した上で,

③ソフトウェア全体における表示画面の選択や相互の牽連関係の共通部分やその独自性等も考慮しつつ,製品B表示画面に接する者が,その全体として,製品K表示画面の表現上の本質的な特徴を直接感得することができるどうかを検討して判断すべきであると解される。

特に,①,②のような比較対照にとどまらず,③の太字部分のように個々の画面だけにとどまらず,全体を考慮するというところが注目される。

そして,具体的には13種類の画面についてそれぞれ製品Kと製品Bの対比が行われた。

判例DBで見ることができる判決別紙には画質は悪いが現物が掲載されている。

<製品Kの単品分析画面>

まず共通する部分について、

両製品は,(ⅰ)画面の上部にメニューバーが表示され,製品Bにおいて「仕上率管理」と「HT処理」が追加されていることや,「棚卸」と「ロケ管理」の位置が逆であることを除けば,その項目名や配列順等が同一であること,(ⅱ)商品抽出条件ブロックにおいては,検索条件として,縦配列で「商品コード」や「書名」,「著者名」,「発売日」,「大分類」,「出版社」,「商品メモ」の各項目が表示され,項目の順番も一致していること,(ⅲ)商品分析条件ブロックにおいては,縦配列で「店舗」,「期間」及び「店舗表示順」という項目が表示され,項目の順番も一致していることなどにおいて共通すると認められる。

としつつも、

上記(ⅰ)の共通部分に関し,画面の最上段にメインメニューを配し,そこに表示された各メニューをクリックすることにより,画面の表示内容の切替えを可能にすることは,アイデアにすぎず,メニューバーに具体的に表示されている個々のタブはいずれも基本的な書店業務であって,その名称の選択,配列順序等の具体的な表現において,創作者の思想又は感情が創作的に表現されているということはできない(以下,他の画面に表示されるメインメニューについても同様である。)。また,「単品分析」という用語についても,個々の商品を「単品」と称することに創作性があるということはできない。

上記(ⅱ)及び(ⅲ)の共通部分に関しても,複数の検索条件を設定することで商品を絞り込むというのは,それ自体はアイデアに属する事柄であるところ,検索条件として具体的に表示されている各項目は,書籍を特定し,あるいは店舗毎の分析をするために必要な一般的な情報であり,その名称の選択,配列順序及びそのレイアウトといった具体的な表現において,創作者の思想又は感情が創作的に表現されているということはできない。

K社が主張するその余の共通点も,製品Kの単品分析画面における表現上の本質的な特徴を直接感得させるものということはできない。

と,共通点は,本質的な特徴を直接感得させるものではないとした。

さらには,両画面の相違点として,

かえって,製品Kは青を基調とした配色を画面全体で採用しているのに対し,製品Bは赤を基調とした配色を採用しており,その配色が異なる(配色の差異については,差違の程度は異なるものの,K社主張に係る全ての画面に共通する相違部分である。)。

また,製品Kでは,商品抽出条件の検索条件を縦に並べた上で,商品の検索結果が新たな画面において表示されるのに対し,製品Bでは商品抽出条件の検索条件ブロックを左右に分けて,それぞれに検索条件が縦配列され,商品検索結果が商品分析条件(ブロック④)の下に表示されるという相違部分が存在する。これらの相違部分により,利用者が画面全体から受ける印象は相当異なる。

以上のとおり,両製品の単品分析画面に関する共通部分は,アイデアに属する事項又は表現上の創作性がない部分にすぎず,上記の相違部分の存在も併せ考えると,製品Bの単品分析画面に接する利用者が製品Kの同画面における本質的な特徴を感得することができないというべきである。

このように述べて,すべての画面についても複製・翻案を否定した。

(2)編集著作物としての著作権侵害

裁判所は,次のように述べてソフトウェアの表示画面全体が編集著作物に当たる場合があるとした。

著作権法12条1項は,編集物で素材の選択又は配列によって創作性を有するものは著作物として保護すると規定するところ,K社は,製品Kの表示画面全体をみた場合,当該画面の選択及び配列に創作性があるので,製品Kは全体として編集著作物に当たると主張する。

前記判示のとおり,製品Kのようなビジネスソフトウェアは,一定の業務フローを前提としていることから,単一の画面表示で完結することはなく,業務の種類ごとに複数の画面を有し,画面に表示された特定の項目をクリックすると次の画面に遷移するなど,利用者は同一階層又は異なる階層に設けられた複数の表示画面全体を利用して作業を行うことが想定されている。

かかるビジネスソフトウェアの特性を考慮すると,一定の業務目的に使用される各表示画面を素材と考え,各画面の選択とシステム全体における配置,更には画面相互間の牽連性に創作性が認められる場合には,素材の選択及び配列に創作性があるものとして,当該ソフトウェアの表示画面が全体として編集著作物に当たるとの考え方も一般論としてはあり得るところである。

もっとも,結論としては侵害を否定している。

本件において,K社は,製品Kの表示画面の最上部にメニュータグを常時表示し,各タグに具体的な業務名を明記した上で,どの画面からも次の業務に移行できるようにしていること,画面の中央にサブメニュー画面を用意し,日,週,月単位の売上情報,他店舗,定期改正,リクエスト管理の情報につき,画面遷移なしに表示することを可能にしていることなどを根拠として,当該表示画面の選択と配列に創作性があると主張する。

しかし,前記1(4)で判示したとおり,画面の最上部にメニュータグを常時表示し,そのいずれの画面からも次の業務に移行できるようにすることや,画面の中央にサブメニュー画面を用意し,画面遷移なしに表示することは,利用者の操作性や一覧性あるいは業務の効率性を重視するビジネスソフトウェアにおいては,ありふれた構成又は工夫にすぎないというべきであり,製品Kにおける表示画面の選択や相互の牽連性等に格別な創作性があるということはできない。

その他,本件において,製品Kが,これを構成する各表示画面の選択,システム全体における各画面の配置,画面相互の牽連性などの点において創作性を有すると認めるに足りる証拠はない。

結果として,K社のすべての請求を棄却した。

読書メモ:「感謝」で思考は現実になる~「許しの筋肉」を鍛える~

引き寄せの法則で使われる「許す」という言葉を、あなたはどのように解釈しているだろうか?

ここでいう「許し」とは、とにかく目の前にあることを許すということだ。それが壊れた車でも、かんしゃくを起こした2歳児でも、「たくさん税金を払え」という通知であっても、すべて受け入れる。

ちなみに「許す」という言葉で連想したのはシンドラーのリストの下記シーン。

自由と力は、身の回りのすべてに感謝するという姿勢から生まれる。

そのためには下記のような単純な事柄で練習を積み重ねて「許しの筋肉」を鍛えるのが良い、

なかやまきんにくんを鍛えるのではない、「許しの筋肉」を鍛えるのだ!

- 「私は朝の光が窓を通って窓に流れ込むのを許す」

- 「私は犬がベッドの横で音を立ててえさを食べるのを許す」

- 「私は蛇口から出た水が歯ブラシを濡らすのを許す」

- 「私はミント味の歯磨き粉が口の中をさっぱりさせるのを許す」

- あなたが何をしても、あなたの人生に何が起こっても、全ての源から切り離されることは絶対にない

- あなたはこの宇宙で最も愛されている存在だ。今、あなたが知っている「愛」という言葉は、全ての源とあなたとの永遠の深いつながりの、ほんの一部しか表現していない。

- あなたはこの名前のないものと永遠につながっているから、世界を創造する力を持っている。そもそもあなたはそのために存在するのだ。

ソーシャルアナライザーの紹介 / Social Analyzer - API, CLI & Web App for analyzing & finding a person's profile across +1000 social media \ websites

Social Analyzerにはさまざまな分析モジュールと検出モジュールが含まれており、調査プロセスで使用するモジュールを選択することができます。

検出モジュールは、異なる検出技術に基づく評価メカニズムを利用し、0から100までのレート値を生成します。このモジュールは、誤検出を少なくすることを意図しており、このWikiリンクで文書化されています。

このOSINTツールによる分析と公開された抽出情報は、ネットいじめ、サイバーブルーミング、サイバーストーキング、誤報の拡散などの疑わしい、または悪意のある行為に関連するプロファイルの調査に役立つ可能性があります。

ソーシャルアナライザーは、デジタルインベスティゲーターとOSINTプラクティショナーに強くお勧めできる非常に優れたツールです。

このプロジェクトは、「現在、資源が限られている国の一部の法執行機関で利用されている」。

https://github.com/qeeqbox/social-analyzer

So·cial Me·di·a

ユーザーがコンテンツを作成・共有したり、ソーシャルネットワーキングに参加できるウェブサイトやアプリケーションのこと - Oxford Dictionary

APP (Preferred!)

標準的なlocalhostのWEB APP URL:http://0.0.0.0:9005/app.html

CLI

特徴

- 文字列と名前の解析(順列と組合せ)

- 複数の手法によるプロファイルの検索 (HTTPSライブラリ & Webdriver)

- マルチプロファイル検索(相関関係に使用-、で区切られた任意の組み合わせ)

- マルチレイヤー検出 (OCR、ノーマル、アドバンスド、スペシャル)

- Ixoraを利用したプロファイル情報の可視化(メタデータとパターン)

- メタデータ&パターン抽出(Qeeqbox OSINTプロジェクトより追加)

- メタデータの強制グラフ化(ExtractPatternsが必要)

- ランキング上位や国別で探す(Alexaランキング)

- タイプ別検索(アダルト、音楽など - ウェブサイトの自動統計情報)

- プロファイルの統計情報と静的情報(カテゴリー別国名)

- クロスメタデータの統計(Qeeqbox OSINTプロジェクトより追加)

- 不要な出力への自動振り分け(javascriptを有効にするなど。)

- 検索エンジン検索 (Google API - オプション)

- カスタム検索クエリ(Google API & DuckDuckGo API - オプション)

- プロフィールのスクリーンショット、タイトル、情報、ウェブサイトの説明文

- 名前の由来、名前の類似性、言語別の共通語検索

- プロフィール年齢検索(限定解析)

- カスタムユーザエージェント、プロキシ、タイムアウト、暗黙の待機

- Python CLI & NodeJS CLI (FindUserProfilesFastオプションに限定)

- グリッドオプションによるチェックの高速化(docker-composeに限定)

- ログをフォルダまたはターミナルにダンプ(簡略化)。

- Findinggetting profile workersの調整 (デフォルト15)

- 失敗したプロファイルの再チェックオプション

- プロファイルをgood, maybe, badでフィルタリングする。

- 解析結果をJSONファイルとして保存

- WebインターフェースとCLIの簡素化

インストールと実行

Linux (As Node WebApp)

sudo apt-get update

#Depedning on your Linux distro, you may or may not need these 2 lines

sudo DEBIAN_FRONTEND=noninteractive apt-get install -y software-properties-common

sudo add-apt-repository ppa:mozillateam/ppa -y

sudo apt-get install -y firefox-esr tesseract-ocr git nodejs npm

git clone https://github.com/qeeqbox/social-analyzer.git

cd social-analyzer

npm ci

npm startLinux (As Node CLI)

sudo apt-get update

#Depedning on your Linux distro, you may or may not need these 2 lines

sudo DEBIAN_FRONTEND=noninteractive apt-get install -y software-properties-common

sudo add-apt-repository ppa:mozillateam/ppa -y

sudo apt-get install -y firefox-esr tesseract-ocr git nodejs npm

git clone https://github.com/qeeqbox/social-analyzer.git

cd social-analyzer

nodejs app.js --username "johndoe"

#or

nodejs app.js --username "johndoe,janedoe" --metadata --top 100

#or

nodejs app.js --username "johndoe" --type "adult"

Linux (As python package)

sudo apt-get update

sudo apt-get install python3 python3-pip

pip3 install social-analyzer

python3 -m social-analyzer --username "johndoe"

#or

python3 -m social-analyzer --username "johndoe" --metadata --top 100

#or

python3 -m social-analyzer --username "johndoe" --type "adult"Linux (As python script)

sudo apt-get update

sudo apt-get install git python3 python3-pip

git clone https://github.com/qeeqbox/social-analyzer

cd social-analyzer

pip3 install –r requirements.txt

python3 app.py --username "janedoe"

#or

python3 app.py --username "johndoe" --metadata --top 100

#or

python3 app.py --username "johndoe" --type "adult"Importing as an object (python)

#E.g. #1

from importlib import import_module

SocialAnalyzer = import_module("social-analyzer").SocialAnalyzer(silent=True)

results = SocialAnalyzer.run_as_object(username="johndoe",silent=True)

print(results)

#E.g. #2

from importlib import import_module

SocialAnalyzer = import_module("social-analyzer").SocialAnalyzer(silent=True)

results = SocialAnalyzer.run_as_object(username="johndoe,janedoe",silent=True,output="json",filter="good",metadata=False,timeout=10, profiles="detected")

print(results)Linux, Windows, MacOS, Raspberry pi.

social-analyzer --h

Required Arguments:

--username E.g. johndoe, john_doe or johndoe9999

Optional Arguments:

--websites A website or websites separated by space E.g. youtube, tiktokor tumblr

--mode Analysis mode E.g.fast -> FindUserProfilesFast, slow -> FindUserProfilesSlow or special -> FindUserProfilesSpecial

--output Show the output in the following format: json -> json outputfor integration or pretty -> prettify the output

--options Show the following when a profile is found: link, rate, titleor text

--method find -> show detected profiles, get -> show all profiles regardless detected or not, all -> combine find & get

--filter Filter detected profiles by good, maybe or bad, you can do combine them with comma (good,bad) or use all

--profiles Filter profiles by detected, unknown or failed, you can do combine them with comma (detected,failed) or use all

--countries select websites by country or countries separated by space as: us br ru

--type Select websites by type (Adult, Music etc)

--top select top websites as 10, 50 etc...[--websites is not needed]

--extract Extract profiles, urls & patterns if possible

--metadata Extract metadata if possible (pypi QeeqBox OSINT)

--trim Trim long strings

--gui Reserved for a gui (Not implemented)

--cli Reserved for a cli (Not needed)

Listing websites & detections:

--list List all available websites

Setting:

--headers Headers as dict

--logs_dir Change logs directory

--timeout Change timeout between each request

--silent Disable output to screen週刊OSINT 2022-04号 / WEEK IN OSINT #2022-04

WEEK IN OSINT #2022-04

今号は、キャプチャされたページからTikTokのOpSecに至るまで、本当に盛りだくさんです

今週はどんな一週間だったでしょうか。たくさんの素晴らしいことを教えてもらい、本当に書きたいトピックがたくさんありましたが、時間が足りませんでした。でも、何とか時間を見つけて、とても興味深いトピックについて書くことができたので、うれしいです。GRUが運営するニュースメディアや、Maltegoの新しいプラグインなど、今回もたくさんの新しいトリックを学び、飛び込むべき新しいトピックを見つけることができました。OSINTコミュニティとこれらのことを共有してくれたことに感謝し、私はそれらを収集し、以下のトピックについてお送りします。

- URL Shorteners

- Ginger__T on Telegram

- Maigret and Maltego

- Archived Pages

- GRU's Galaxy

- AHREFS and Backlinks

- State of OSINT

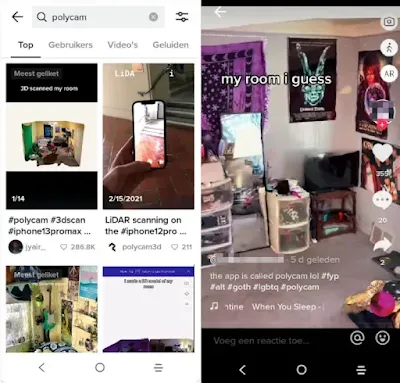

- Polycam

小技: URL Shorteners

少し前になりますが、OSINTtechniquesでURL短縮ツールの背後にあるリンクを表示する方法について紹介しました(元ツイートへのリンク)。これらのサービスの多くは、その背後にあるリンクをプレビューする何らかの方法を備えており、それ以外にもリンクの行き先を示すことができるサービスがありますが、ここでは最もよく使われているサービスのいくつかを少し紹介します。

| Service | Info |

|---|---|

| Bitly.com | Add + at the end |

| Cutt.ly | Add @ at the end, or visit https://cutt.ly/preview and turn on preview mode |

| Goo.gl | Add: + at the end |

| Is.gd | Add - at the end |

| Tiny.cc | Add = at the end , or ~ for statistics |

| TinyURL.com | Add preview. in front of the URL |

サードパーティのプラットフォームを使ってリンクをたどりたい場合は、Week in OSINT 2021-16の最後の項目を参照してください。さらに多くのサービスとそのリンクをプレビューする方法は、@SEINT_plがキュレーションした素晴らしいチートシートで見ることができる。

Ginger__TがTelegramに関する記事を書き、いくつかの機能、リサーチオプション、Telegramアカウントを持つことのOpSecについて話しています。彼はまた、私が見逃していた新機能を発見しました。最新のTelegramクライアントの新しいアプリ内翻訳機能です。

I have completed a new #OSINT Blog Post - Telegram Fundamentals - Watch out for false negatives, https://t.co/kqhcSdrLol pic.twitter.com/jhNhqBgTxu

— Ginger T (@Ginger__T) January 27, 2022

ツール: Maigret and Maltego

Twitterユーザーの@OS2INTさんが、Maltegoの新たな変身について書いています。Maigretです。その記事にはインストール方法が明記されていませんでしたが、少し検索してみると、素晴らしい @Soxoj のオリジナルの GitHub ページにたどり着きました。Maltegoにインストールした後、それを実行するのは簡単でした! Maltegoのための素晴らしいローカル変換がまた一つ増えました。

Link: https://github.com/soxoj/maigret-maltego

Os2Int Artcile: https://os2int.com/toolbox/...

小技: Archived Pages

Jordan WildonがTwitterで、Internet Archiveから特定のURLとそのサブページでキャプチャされたすべてのページを取得する方法を紹介する素晴らしいヒントを教えてくれた。彼の例では、Twitterのプロファイルを使用していますが、これはあなたが望むものに変更することができます。私は、彼が示した例を少し変更して、ツイートだけを表示し、他は何も表示しないようにしました。

https://web.archive.org/web/timemap/?url=https://twitter.com/{UserID}/status&matchType=prefix&collapse=urlkey&output=json&fl=original,mimetype,timestamp,endtimestamp,groupcount,uniqcount&filter=!statuscode:[45]..&limit=100000この URL の中身をすべて見てみましょう。GitHub にあるオプションを確認します。

| Item | Explanation |

|---|---|

| web/timemap/ | An overview of all archived 'Mementos' and their date (RFC 8079) |

| matchType=prefix | Return all matches that have the same URL path that was provided |

| collapse=urlkey | Only return unique URL's, even if there are multiple captures |

| output=json | The output format, if removed it returns just a list of URL's |

| fl=original | Field order, where original defaults to alphanumerical order |

| mimetype | Will include the type of content, ie: text/html, application/json, unk(own) but it's quite useless here |

| timestamp | Show the timestamp of first capture |

| endtimestamp | Show the timestamp of latest capture |

| groupcount | Total amount of captures for the URL |

| uniquecount | Amount of unique captures for the URL |

| filters= | A set of filters, they follow right after this |

| !statuscode:[45] | Don't show pages matching a specific HTTP error code. This is probably a typo, since HTTP error code 45 doesn't exist. Maybe this should be: 404, meaning 'page not found' |

| limit=100000 | Maximum amount of results to return |

記事: GRU's Galaxy

Openfactoは、ロシアの諜報機関GRUと関係があると思われる1300以上のオンラインニュースポータルに関するレポートを発表しました。この報告書は、ウェブサイトがどのように発見されたかを説明するだけでなく、非常にタイムリーなドメイン名の登録、そのコンテンツ、「ターゲットオーディエンス」の所在地についても洞察を与えている。この組織による、興味深く、よくできた報告書です。

Twitterユーザーの@UnleashedOsintは、AHREFS内の膨大なデータへのアクセス権を購入できることを知りました。バックリンク'セクションを見ると、Telegramについて、そしてきっと他のプラットフォームについても追跡され、得られる情報がたくさんあることがわかりました。興味深いツイートのスレッドはこちら

#Telegram #Security #OSINT

— osint_unleashed (@UnleashedOsint) January 26, 2022

A Thread

Out of curiosity wanted to see if all backlinks for Telegram are openly attainable-they were offered to me by AHerfs Backlink checker for $7 USD. It appears that is indeed the approx cost, I think some are missing- provided with over 27 MiL pic.twitter.com/bVC34YqaVJ

サイト: State of OSINT

昨年、「State of OSINT」が発表されましたが、今年も登場します。Ginsberg5150は専門家チームを集め、2021年のハイライト、トレンド、ツール、OSINTランドスケープにおける変化について話している。このインタビューは、さまざまな専門領域におけるOSINTの現状をよくまとめている。

小技: Polycam

これからのトレンドは、iPhoneに搭載されたLiDARを使って、Polycamを使い、その場所の3Dビューを作成することだと思われます。これは面白い展開で、人の家の中を見ることができる上に、いつかこのような映像が捜査に登場しても不思議ではありません。この新しいトレンドを指摘してくれた@Zewensecに感謝します。

侵入型ランサムウェア攻撃を受けたら読むFAQ(転載)

ランサムウェアを用いた攻撃は、一台から数台の端末の感染被害から、業務停止を引き起こす大規模な感染被害に至るものまでさまざまです。本FAQでは、企業や組織の内部ネットワークに攻撃者が「侵入」した後、情報窃取やランサムウェアを用いたファイルの暗号化などを行う攻撃の被害に遭った場合の対応のポイントや留意点などをFAQ形式で記載します。

JPCERT/CCでは、こうした攻撃を他のランサムウェアを用いた攻撃と区別し、「侵入型ランサムウェア攻撃」と呼びます。

ネットワーク内部の複数のシステムでファイルの拡張子が変わり開封できなくなった、自組織から窃取されたとみられるファイルを暴露する投稿が行われた、または攻撃者から通知が届いたなどの状況を確認している場合、この攻撃の被害を受けている可能性があります。被害に遭われた企業や組織のCSIRTおよび情報セキュリティ担当の方は、インシデント対応を進める上での参考情報として本FAQをご活用ください。

ループイフダン利益・相場まとめ2022年01月

ループイフダン利益・相場まとめ2022年1月【アイネット証券】

2022年1月のループイフダンの利益レポートが出た。

25Bで稼働させた場合の利益は1,000通貨で7,500円

50Bで稼働させた場合の利益は1,000通貨で5,000円

現在のループイフダン稼働状況は25Bを2,000通貨、50Bが2,000通貨となる。

となると、想定利益は25,000円

実績はというと、1/1~1/31の売買益が22,319円

ん、ちと足りない(||゚Д゚)ガァァーーーン(゚Д゚||)

一方で、ループイフダン口座資産に対する目標利益率(年4%≒22,242円/月)に対してはクリアできている。

ただ、スワップ益が63,845円だったので、大きな利益となった。

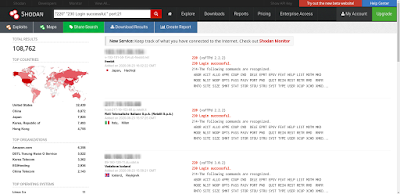

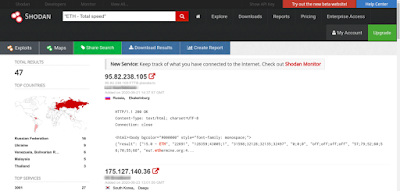

SHODAN活用ガイド / Shodan Cheat Sheet: Keep IoT in your Pocket(転載)

Found a fantastic Cheat Sheet for Shodan. Thanks to @The_Dark_Source #OSINT #Shodan #OSINTdojo thedarksource.com/shodan-che…

SHODANの検索エンジンをプロのように使いこなすための、SHODANの検索フィルターやSHODANのドークを含む、個人的なSHODANチートシートを共有しています。これを使えば、簡単に目的の検索結果を得ることができます。

GoogleやBing、Yahooなどのコンテンツ検索エンジンとは大きく異なります。GoogleやBing、Yahooのようなコンテンツ検索エンジンは、ウェブページのデータをクロールして検索用のインデックスを作成するのに対し、Shodanはポートを照会して結果のバナーを取得し、検索用のインデックスを作成します。

あなたがサイバーセキュリティの分野にいるならば、Shodan検索エンジンについてよく知られているはずです。Shodanは、インターネット上の特定の種類のコンピューター(ルーター、ウェブカメラ、サーバーなど)を、さまざまなフィルターを使って見つけることができるIoT検索エンジンです。Shodanは、ターゲットの受動的な偵察や、測定ツールとして最適なリソースです。

https://shodan.io/ を開いて、このSHODANチートシートのコマンドを打ち込むだけです。

SHODAN活用ガイド

Server:

特定のサーバーヘッダーフラグを持つデバイスやサーバーを探すことができます。脆弱なサーバーを調査することができます。

server: "apache 2.2.3"または、直接フラグを入れても検索できます。

apache 2.2.3hostname:

世界中の特定のホスト名を持つデバイスを検索します。ホスト名とは、ネットワークに接続されている機器に付けられたラベルのことで、WWWなどの各種通信で機器を見分けるために使用されます。SHODANチートシートに含まれる複数のフィルターを使用して、検索結果を絞り込むことができます。

server: "apache" hostname:"google"net:

IPアドレスまたは/x CIDRに基づいて、デバイスやマシンを検索します。このフィルターは、IPレンジや特定のIPアドレスとサブネットマスクの検索にも使用できます。

net:34.98.0.0/16os:

オペレーティングシステムに基づいてデバイスを検索します。特定のOSを搭載しているデバイスをすべて見つけることができます。これは、侵入テスト担当者が、特定のオペレーティングシステムのフィルタを持つ脆弱なマシンを見つけるのに役立ちます。

os:"windows xp"port:

開いているポートに基づいてデバイスを検索します。"port "フィルターは、特定のオープンポートを持つマシンを検索対象にすることができます。

proftpd port:21org:

このフィルターでは、特定の組織のデバイスを検索することができます。

org:"Google"SHODANでは、orgフィルターを使って複数のフィルターを使い、検索結果を絞り込んだり、数百万件の中から検索結果を並べ替えることができます。

city:

特定の都市のデバイスを検索します。例えば、ムンバイの都市のみに絞って検索したい場合は、以下のようになります。

city:"Mumbai"country:

特定の国のデバイスを検索します。例えば、インドだけに絞って検索したい場合

country:"IN"geo:

一定の半径内にある特定の経度と緯度による地理的座標を与えてデバイスを見つける。

geo:"48.1667,-100.1667"before/after:

「after」と「before」のフィルターを使うと、特定の日付の後や前にデバイスを表示することができます。

使用できるフォーマットはdd/mm/yyyyです。

nginx before:13/04/2020 after:13/04/2018has_screenshot

このフィルターは、スクリーンショットが利用可能な結果のみを返します。

has_screenshot:true city:"George Town"Wifi Passwords:

Shodanでは、無線LANの平文のパスワードを見つけることができます。

html:"def_wirelesspassword"Surveillance Cams:

ユーザー名:admin、パスワード:passwordで監視カメラのデータを取得する

NETSurveillance uc-httpdまた、以下のコマンドを使用することもできます。

Android Webcam ServerCitrix:

Citrix Gatewayの検索を行います。

title:"citrix gateway"Windows RDP Password:

ただし、セカンダリウィンドウズ認証を含む場合があります。

"\x03\x00\x00\x0b\x06\xd0\x00\x00\x124\x00"Misconfigured WordPress Sites:

wp-config.phpにアクセスすると、データベースの認証情報が表示されます。

http.html:"* The wp-config.php creation script uses this file"ワードプレスのメイン設定ファイルにアクセスし、設定ミスのサイトの認証情報やAUTH_KEYなどの機密情報を取得することができます。

Mongo DB servers:

mongo DBサーバの情報を提供するフィルタです。

"MongoDB Server Information" port:27017 -authenticationFTP servers allowing anonymous access:

完全なアノニマス・アクセスのためのデータを取得します。

"220" "230 Login successful." port:21Jenkins:

すべてのJenkinsのための検索 制限のないダッシュボード

x-jenkins 200Telnet Access:

telnetアクセスにパスワードが必要な機器を検索します。

port:23 console gatewayEtherium Miners:

ETHを実行しているマイナーを表示しています。

"ETH - Total speed"