ラテラルムーブメント(横展開)の時に、いまだによく使われる SMB。横展開が実行された時の Windows ログの出方についてまとめてあります。検出のロジックを考える時の参考になります。

Detecting Lateral Movement 101:

link.medium.com/hInMBpJJs8:

ラテラルムーブメント(横展開)の時に、いまだによく使われる SMB。横展開が実行された時の Windows ログの出方についてまとめてあります。検出のロジックを考える時の参考になります。

Detecting Lateral Movement 101:

link.medium.com/hInMBpJJs8

Detecting Lateral Movement 101:

link.medium.com/hInMBpJJs8

ーー日本語訳ーー

横方向の動きの検出101:Windowsログ分析による動きのSMB / Windows管理共有の追跡

MITER ATT&CKリファレンス:戦術:横方向移動

テクニックID:T1021(リモートサービス)

サブテクニックID:T1021.002(リモートサービス:SMB / Windows管理共有)

通常、敵対者は、被害者組織に最初の足がかりを得ると、横方向への移動を開始します。一旦初期アクセスを得ると、彼らは特権をエスカレートさせ、エスカレートした特権を使って横方向に移動し、マルウェアを伝播させたり、さらに偵察して標的情報を収集したりします。

脅威のアクターが組織内を横方向に移動する手法は数多くあります。MITER ATT&CKは、攻撃者が使用するこれらのさまざまな技術を理解するために開始するのに最適なリソースの1つです。MITERは、「ラテラルムーブメント」戦術の下で、これらのラテラルムーブメント手法を非常によく整理しています。サイバー防御チームとして、これらの手法とそれらを検出および防止する方法を知っておく必要があります。

この簡単な記事では、敵が横方向に移動するために使用する手法の1つであるSMB共有について説明します。これは、組織内を横方向に移動するために敵対者が最も使用する手法の1つであり、それを検出する準備を整える必要があります。Windowsイベントログによって、この手法がどのように見えるかがわかります。

敵対者はこの手法をどのように使用しますか?

攻撃者は、管理者が合法的な作業に使用するデフォルトのWindows管理共有を乱用します。Windowsでは、デフォルトで、管理活動用にc $、admins $、IPC $共有が提供され、これらの共有には管理アカウントからアクセスできます。

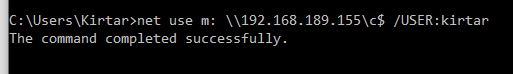

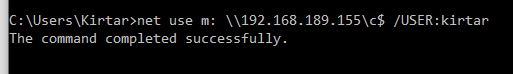

攻撃者は、特権が昇格すると、これらの共有を他のワークステーションからマッピングし、マルウェアをコピーして横に移動します。さらに、net.exeなどのWindowsネイティブサービス/バイナリを使用して共有に接続し、移動によって生成されるアラートを削減します。以下は、ネットワーク共有をマップするために使用されるコマンドです。このコマンドは、マシン192.168.189.155のc $ admin-shareをマップします。

net use m:\\ 192.168.189.155 \ c $ / USER:kirtar

このアクティビティは、ソースマシンとターゲットマシンでいくつかのフットプリントを作成します。このアクティビティを検出するには、どのログを探す必要がありますか?

横方向の動きをどのように検出しますか

これにより、ソースマシンのセキュリティログに2つの重要なログエントリが生成されます。

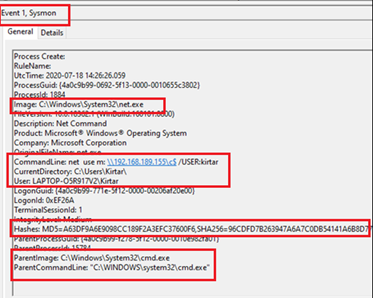

イベントID 4688(SysmonイベントID 1):プロセスの作成[コマンドライン監査を有効にして]イベントID

4648:明示的な資格情報を使用してログオンが試行されました。

4648:明示的な資格情報を使用してログオンが試行されました。

一般的な組織では、通常のユーザーは他のワークステーションまたはサーバーの管理共有を移動してマップしません。したがって、通常のユーザーのワークステーションからのnet.exe(管理共有のマッピング)のSysmon eventid 1(4688 —セキュリティ)を調査する必要があります。

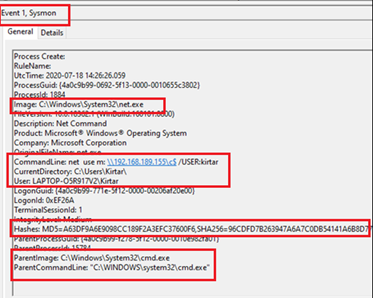

イベントID 1(コマンドラインパラメーター付きの4688)は、次の重要な詳細情報を提供します

-現在のプロセスとそのフルパス- 説明-

元の

ファイル名-

実行時にバイナリと共に渡されるコマンドラインパラメーター

-ユーザーの現在のディレクトリ-

スポーンしたアカウント/ユーザーこのプロセス

-プロセスバイナリイメージの

ハッシュ-親プロセス-

親プロセスコマンドラインパラメータ

-現在のプロセスとそのフルパス- 説明-

元の

ファイル名-

実行時にバイナリと共に渡されるコマンドラインパラメーター

-ユーザーの現在のディレクトリ-

スポーンしたアカウント/ユーザーこのプロセス

-プロセスバイナリイメージの

ハッシュ-親プロセス-

親プロセスコマンドラインパラメータ

次のスクリーンショットは、LAPTOP-O5R917V2 \ kirtarのアカウントを使用して、c $共有がIPアドレス192.168.189.155のマシンにマッピングされていることを示しています。親プロセスは、net.exeがcmd.exeを介して実行されることを示しています。ハッシュ、親プロセスのコマンドライン、イメージパスに関する詳細は、スクリーンショットで確認できます。

これにより、攻撃者がマルウェアをコピーした可能性のあるマシン(宛先)とともに、侵害された可能性のあるアカウントとマシンに関する重要な情報が得られます。

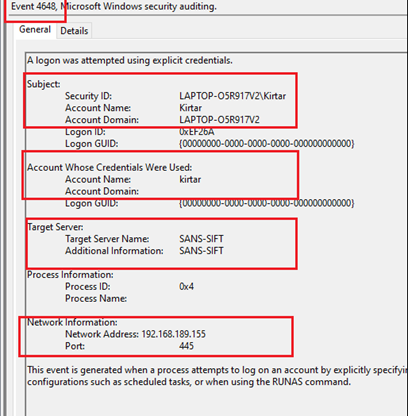

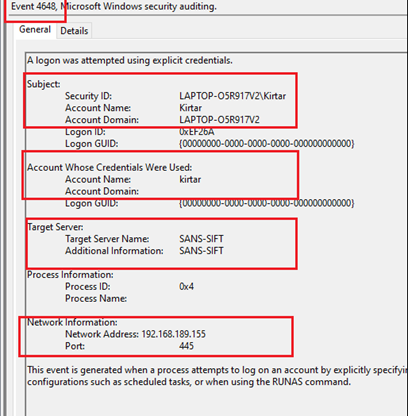

ソースで生成される他のログは4648です。このログは、攻撃者が明示的な認証情報を使用してネットワーク共有をマッピングするときに生成されます。このイベントは、宛先IPとホスト名、および両方のアカウント(元のアカウントと切り替えられたアカウント)に関する非常に重要な情報を提供します。この情報は、前のイベントから受け取った情報を実証するのに役立ちます。以下のスナップショットを見てください。

スクリーンショットに示すように、元のアカウントはLAPTOP-O5R917V2 \ kirtarと切り替えられたアカウントkirtarです(これはリモートマシンへの認証に使用されます)。ターゲットマシンSANS-SIFTのホスト名。さらに、ネットワーク情報は宛先IPアドレス(192.168.189.155)を提供します—これは、前のイベントのコマンドラインパラメーターに対して検証できます。

宛先での検出

同じコマンドで、宛先マシンにもいくつかのログが生成されます。宛先で以下のログが生成されます。

4776-コンピューターがアカウントの資格情報を検証しようとしました

4672-新しいログオンに割り当てられた特別な権限

4624(タイプ3)-アカウントが正常にログオンしました

4672-新しいログオンに割り当てられた特別な権限

4624(タイプ3)-アカウントが正常にログオンしました

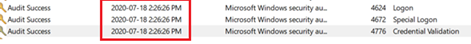

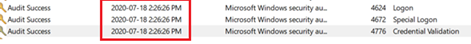

これら3つのイベントすべての時間を確認すると、ほぼ同時にログに記録されています。これらのイベントは、ローカルNTLM認証(4776)がローカル管理アカウント(4672)を介してネットワーク(Type3)で発生するために生成されます。

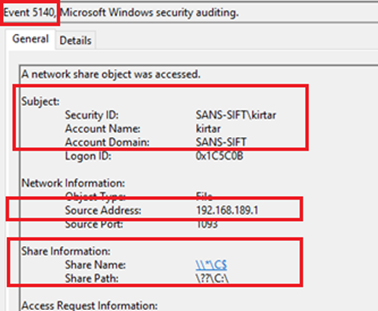

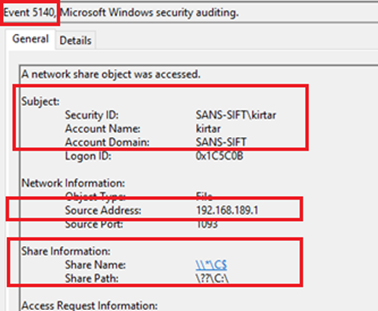

宛先で生成される主要なログの1つは、EventID 5140です。これは、実際のイベント(ネットワーク共有アクセス)の「ログ」です。

このログは、次の情報を提供します

-共有へのアクセス/マッピングに使用されるアカウント-

ソースマシンのIPアドレス(共有へのアクセス元)

-共有の名前とパス

-共有へのアクセス/マッピングに使用されるアカウント-

ソースマシンのIPアドレス(共有へのアクセス元)

-共有の名前とパス

上記で実行したコマンドの結果として生成された5140 EventIDの次のスクリーンショットを参照してください。これは、アカウントSans-SIFT \ kirtarがC $共有へのアクセスに使用されていることを示しています。この共有にアクセスするソースマシンのIPは192.168.189.1です。

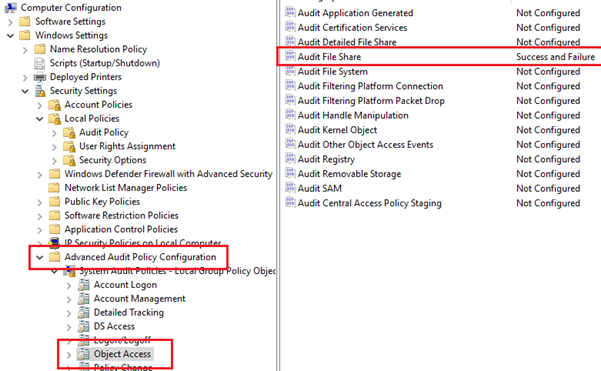

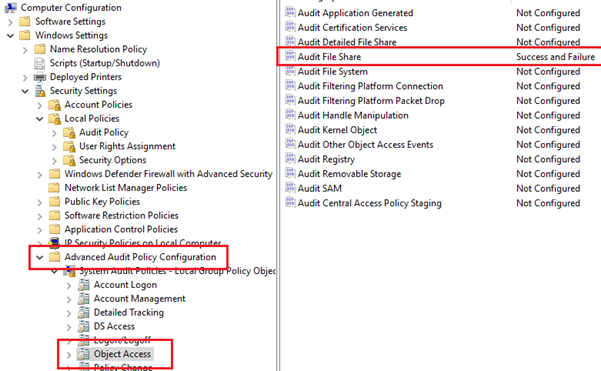

このログに関連する警告がいくつかあります(5140)。このログはデフォルトでは有効になっていません。詳細な監査ポリシー設定の[オブジェクトアクセス]で[ファイル共有]監査を有効にして、GPOで有効にする必要があります。次に、2008R2 +エディションで利用できます。5140に必要な監査ポリシー構成を示す次のスクリーンショットを見てください。

したがって、これまでに見てきたように、この横方向の動きを検出するために活用できるWindowsセキュリティイベントログがかなりあります。正確なフィルターに基づいてアラートを作成すると、精度を向上させ、横方向の動きの検出における誤検知を減らすのに役立ちます。

同様に、イベントログを使用して、他の横方向の移動手法も検出できます。他のテクニックについても記事を書こうと思います。

現時点ではこれで終わりです。読んでいただき、ありがとうございます。

――原文――

Detecting Lateral Movement 101: Tracking movement SMB/Windows Admin Shares through Windows Log Analysis

MITRE ATT&CK Reference : Tactic: Lateral Movement

Technique id: T1021 (Remote Services)

Sub-technique Id: T1021.002 (Remote Services: SMB/Windows Admin Shares)

Adversaries, typically, start moving laterally once they get initial foothold in the victim organization. Once they get initial access, they escalate their privileges and move laterally with the escalated privileges either to propagate their malware or to further reconnaissance & collect the targeted information.

There are many techniques by which threat actors move laterally in the organization. MITRE ATT&CK is one the best resources to start with to understand these various techniques used by the adversaries. MITRE has very well organised these lateral movement techniques under “Lateral Movement” tactic. As a cyber defense team, we should be aware of these techniques and how to detect and prevent them.

In this quick article, I am going to talk about one of the techniques used by the adversaries for moving laterally — SMB Shares. This is one of the most used techniques by adversaries to move laterally in the organization and we should be better prepared to detect it. We will see how Windows Event Logs make this technique highly visible.

How Adversaries Use this technique?

Adversaries abuse the default Windows admin shares that are used by the administrators for legit work. Windows, by default, provides c$, admins$ and IPC$ shares for administrative activities and these shares are accessible through administrative accounts.

Adversaries, once escalated privileges, map these shares from other workstations and copy their malware and move laterally. Moreover, they use windows native services/binaries like net.exe to connect to the shares to reduce any alerts generated by their movement. Following is the command used to map network share — this command maps c$ admin-share of the machine 192.168.189.155.

net use m: \\192.168.189.155\c$ /USER:kirtar

This activity creates a few footprints at the source as well as the target machines.Which logs we need to look for to detect this activity?

How to detect the lateral movement?

This will generate 2 important log entries in Security logs at the source machine.

Event ID 4688 (Sysmon EventID 1): Process Create [ with command line auditing enabled]

EventID 4648: A logon was attempted using explicit credentials.

EventID 4648: A logon was attempted using explicit credentials.

In a typical organization, normal users do not go around and map the admin shares of the other workstations or the servers. Hence, any Sysmon eventid 1 (4688 — security) for net.exe (mapping admin share/s) from the workstation of the normal users should be investigated.

EventID 1 (4688 with command line parameters) provides following key details

-Current Process with its full path

-Description

-Original File Name

-Command Line parameters passed with the binary while executed

-Current directory of the user

-the account/user who has spawn this process

-hashes for the process binary image

-Parent Process

-Parent Process command line parameters

-Current Process with its full path

-Description

-Original File Name

-Command Line parameters passed with the binary while executed

-Current directory of the user

-the account/user who has spawn this process

-hashes for the process binary image

-Parent Process

-Parent Process command line parameters

The following screenshot shows that c$ share is mapped of the machine with IP Address 192.168.189.155 by using account of LAPTOP-O5R917V2\kirtar. The parent process shows that net.exe is executed via cmd.exe. The details related to hash, parent process command lines, image path can be seen in the screenshot.

This gives us crucial information about potentially compromised account and machine along with the machine(destination) where adversaries might have copied their malware.

The other log generated at the source is 4648. This log is generated as attacker uses an explicit credential to map the network share. This event provides very important information about the destination IP & hostname and both of the accounts (original and switched). This information will help us to substantiate the information received from the previous event. Look at the snapshot below.

As shown in the screenshot, the original account is LAPTOP-O5R917V2\kirtar and the switched account kirtar (this is used for authenticating to the remote machine). The hostname of the target machine SANS-SIFT. Furthermore, Network Information provides the destination IP address (192.168.189.155) — this can be verified against the command-line parameters of the previous event.

Detection at the Destination

The same command generates a few logs on the destination machine as well. Following logs are generated at the destination.

4776 — The computer attempted to validate the credentials for an account

4672 — Special privileges assigned to new logon

4624 (Type 3) — An account was successfully logged on

4672 — Special privileges assigned to new logon

4624 (Type 3) — An account was successfully logged on

Look at the time for all these 3 events, they are logged at nearly same time. These events are generated because local NTLM authentication (4776) happens over the network (Type3) via local administrative account (4672).

One of the key logs generated at the destination is EventID 5140. This is “the log” for the actual event — network share access.

This log provides the following information

-the account used for accessing/mapping the share

-IP address of the source machine (from where the share is accessed)

-Name and Path of the share

-the account used for accessing/mapping the share

-IP address of the source machine (from where the share is accessed)

-Name and Path of the share

Please see the following screenshot of 5140 EventID generated as a result of the command that we ran above. It shows that account Sans-SIFT\kirtar is used to access the C$ share. The IP of the source machine from where this share is accessed is 192.168.189.1.

There are couple of caveats related to this log (5140). This log is not enabled by default, this needs to be enabled via GPO by enabling “File Share” auditing under “Object Access” in Advanced Audit Policy Configuration settings. Secondly, it is available in 2008R2+ editions. Look at the following screenshot that shows the audit policy configuration required for 5140.

So, as we have seen there are quite a few windows security event logs that can be leveraged to detect this lateral movement. Creating Alerts based on the precise filters will help in improving precision and reducing false positives in detecting lateral movement.

Similarly, event logs can be used to detect other lateral movement techniques as well. I will try to write articles for other techniques as well.

That’s it for now. Thanks for reading and happy hunting fellas !!

by :

Kirtar Oza

Twitter : @Krishna (kirtar_oza)

LinkedIn: https://www.linkedin.com/in/kirtaroza/

email: kirtar.oza@gmail.com

Kirtar Oza

Twitter : @Krishna (kirtar_oza)

LinkedIn: https://www.linkedin.com/in/kirtaroza/

email: kirtar.oza@gmail.com